tanuki- 2024-05-02 halfkp_1024x2-8-64 Fine-tuning

実験内容

- halfkp_1024x2-8-64 ネットワークを学習させ、レーティングを測定する。

- ランダムパラメーターからの学習には、 Hao を用いて生成した学習データを用いる。

- Fine-tuning に Suisho10Mn_psv を学習データとして用いる。

棋譜生成

ランダムパラメーターから学習させる際の学習データ

| 生成ルーチン | tanuki-棋譜生成ルーチン |

| 評価関数 | Hao (tanuki-.halfkp_256x2-32-32.2023-05-08) |

| 1手あたりの思考 | 深さ最大 9 思考ノード数最大 50,000 ノード |

| 開始局面 | foodgate の 2020 年~ 2021 年の棋譜を使用した。レーティング 3900 以上同士の対局のみ使用した。戦型が角換わりの対局が 10% になるよう調整した。 32 手目までから 1 局面ランダムに選択し、その局面を開始局面とした。ランダムムーブはしなかった。 |

| 生成局面数 | 10 億局面 × 8 セット |

| 生成条件 | 対局は打ち切らず詰みの局面まで学習データに出力した |

| フォルダ名 | tanuki-.halfkp_256x2-32-32.2023-05-08 |

シャッフル条件

ランダムパラメータから学習させる際の学習データ

| 生成ルーチン | tanuki-シャッフルルーチン |

| qsearch() | あり |

| 置換表 | 無効 |

| min_progress | 0.0 |

Fine-tuning に用いる学習データ

| 生成ルーチン | tanuki-シャッフルルーチン |

| qsearch() | あり |

| 置換表 | 無効 |

| min_progress | 0.1 |

機械学習

| 機械学習ルーチン | nnue-pytorch + やねうら王 https://github.com/nodchip/nnue-pytorch/tree/shogi.2024-04-20.halfkp_1024x2-8-64 |

| 学習モデル | halfkp_1024x2-8-64 |

| 学習手法 | ミニバッチ SGD |

| 初期学習率 (lr) | 0.5 収束後 0.05 |

| 最適化手法 | なし |

| 学習率調整手法 | Warmup + Newbob 風 |

| batch-size | 16384 |

| threads | 8 |

| num-workers | 8 |

| accelerator | gpu |

| devices | 1 |

| features | HalfKP |

| max-epoch | 1000000 |

| score-scaling | 361 |

| lambda | 1.0 収束後 0.5 |

| 勝敗項の教師信号 | 0.999 |

| num-batches-warmup | 10000 |

| newbob-decay | 0.5 |

| epoch-size | 1000000 |

| num-epochs-to-adjust-lr | 500 |

| 学習を打ち切る下限 newbob scale | 1e-5 |

| 1 epoch 毎のネットワークパラメーターのクリップ | あり |

| ネットワークパラメーターの量子化 | 量子化なしで学習し、収束後に量子化する。 |

| ネットワークパラメーターの初期化方法 | pytorch のデフォルトの初期化手法で初期化する。 |

| 勾配の正規化 | なし |

| momentum | 0.9 |

| 入玉ボーナス | 入玉時、持ち駒および敵陣三段目までに侵入している駒について、小駒 1 枚につき 20 点、大駒 1 枚につき 100 点、敵陣三段目までに侵入している駒 1 枚につき 20 点追加する。 |

レーティング測定

| 対局相手 | https://docs.google.com/document/d/1FC3FvCxyJV6IRPfwOHOMcAlEoTsjmRY8JZpWkGVpgH8/edit?usp=sharing tanuki-.nnue-pytorch-2024-03-24.1000 |

| 思考時間 | 持ち時間 300 秒 + 1 手 2 秒加算 |

| 対局数 | 5000 |

| 同時対局数 | 64 |

| ハッシュサイズ | 384 |

| 開始局面 | dlshogi 互角局面集の角換わりの割合が 10% になるよう間引いたもの |

実験結果

機械学習

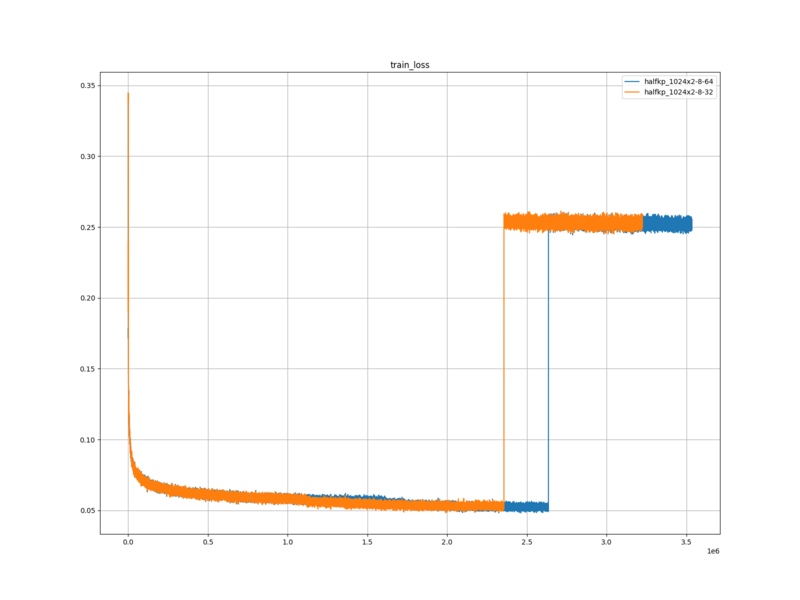

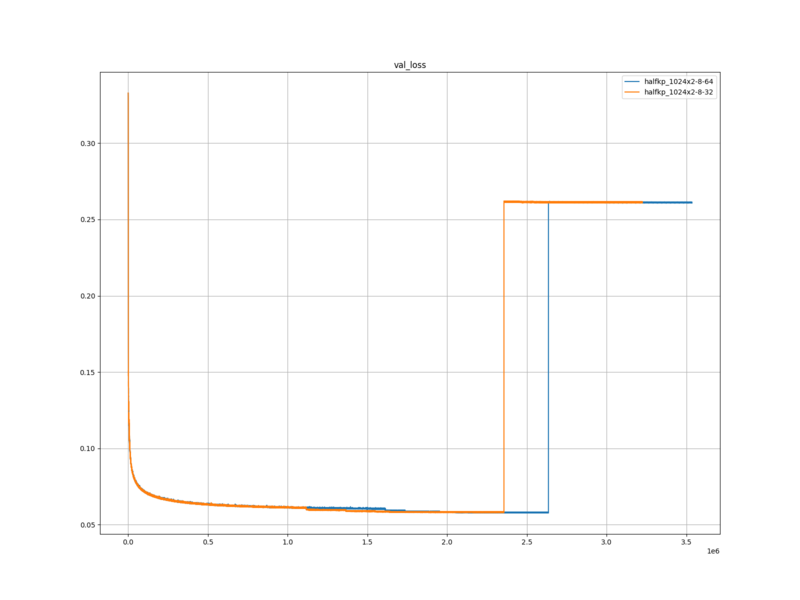

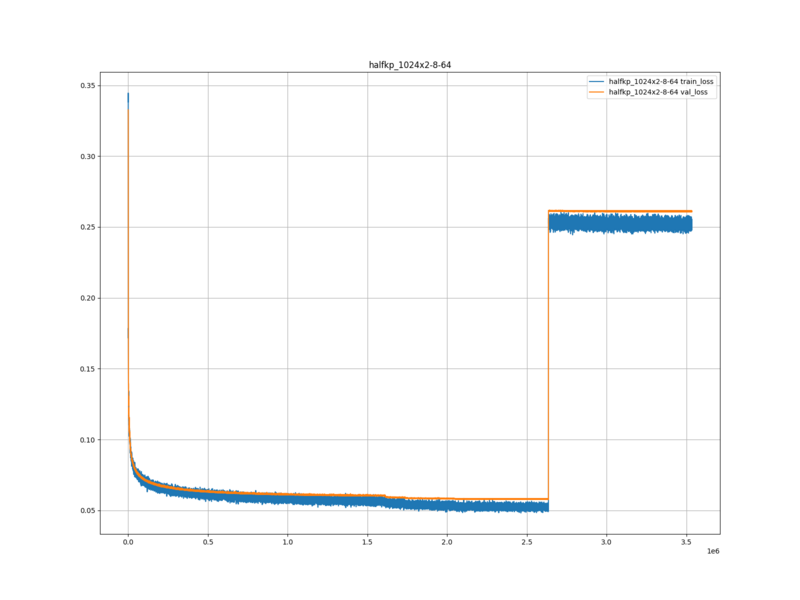

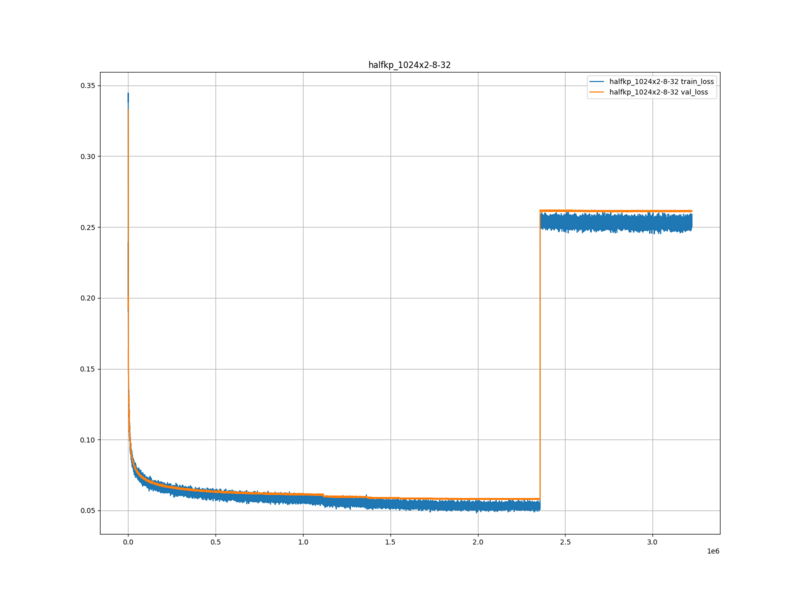

ランダムパラメーターからの学習

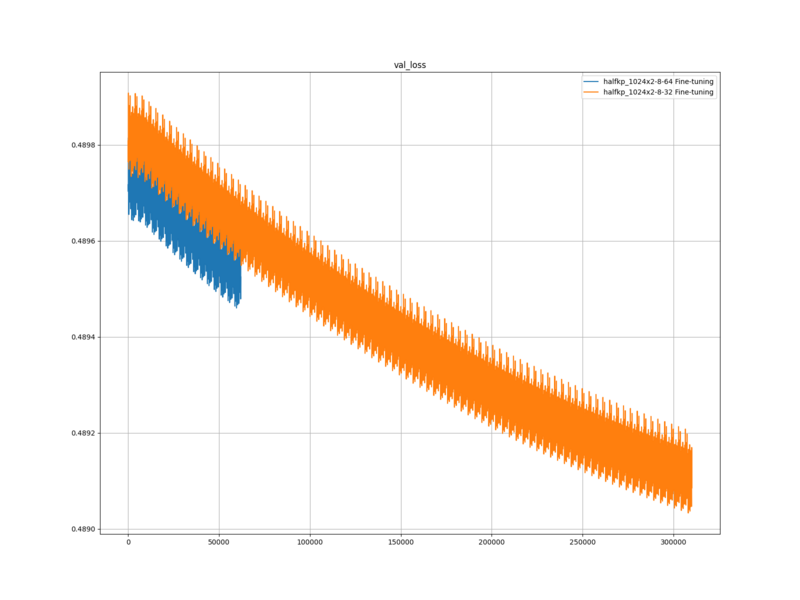

検証ロス

halfkp_1024x2-8-64 … 0.2610738826874763

halfkp_1024x2-8-32 … 0.2612318373649352

Fine-tuning

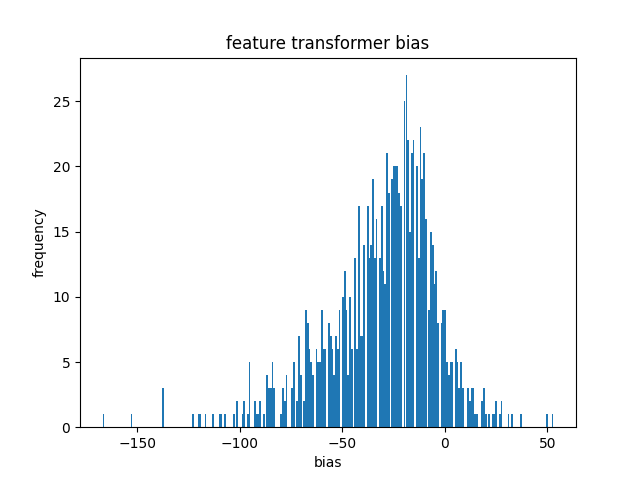

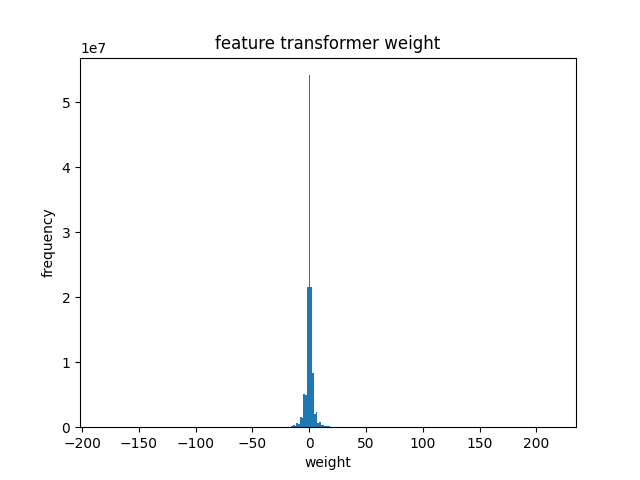

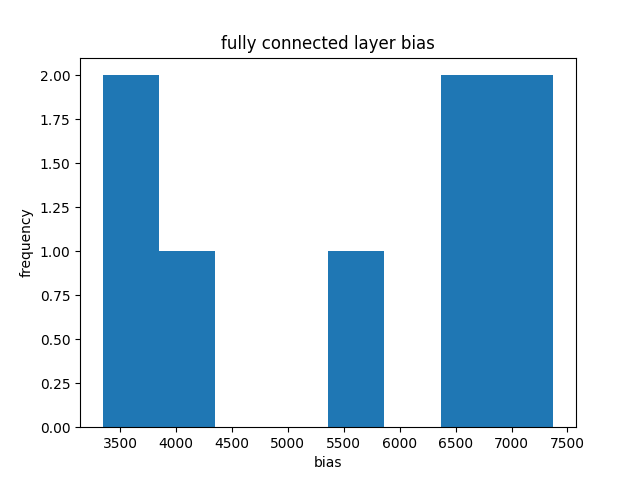

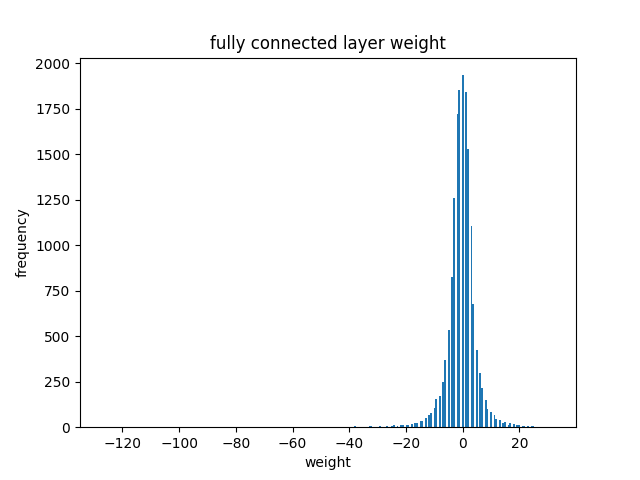

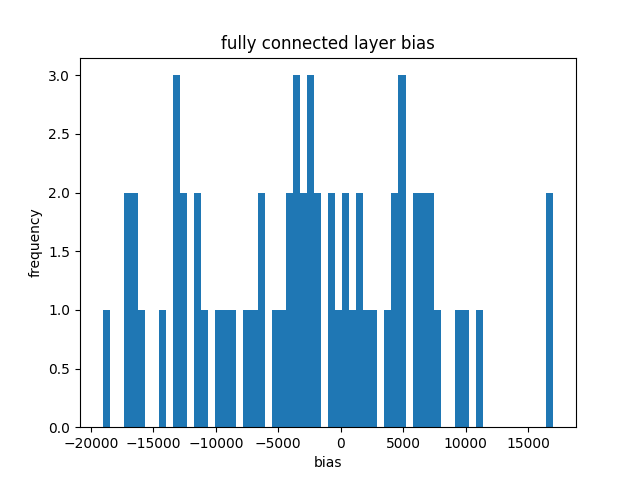

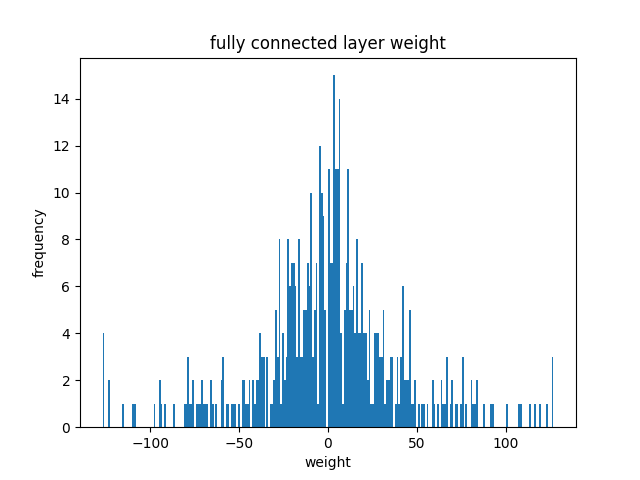

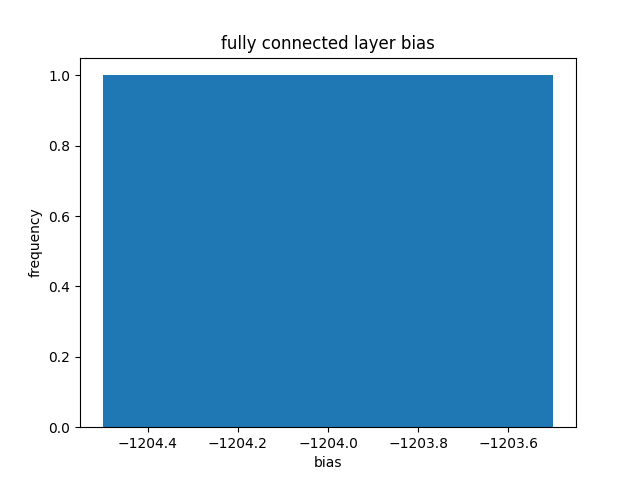

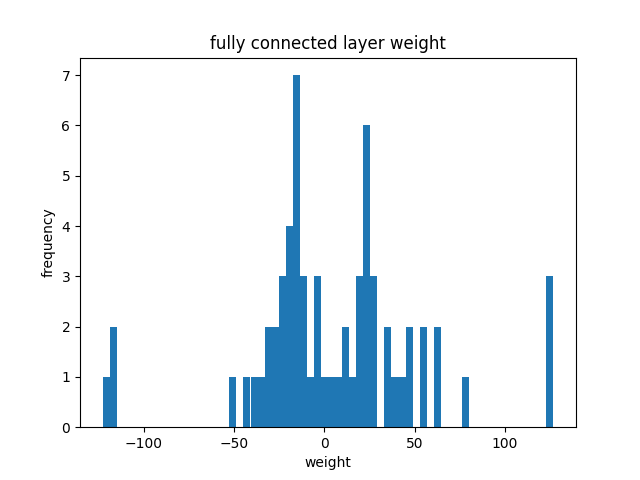

ネットワークパラメーターの分布

mean=-30.4775390625 std=26.578081130981445

mean=-0.00859669130295515 std=3.798966407775879

mean=5599.75 std=1670.2501220703125

mean=-0.4246826171875 std=5.293008327484131

mean=-2664.390625 std=8623.640625

mean=0.38671875 std=40.71420669555664

mean=-1204.0 std=nan

mean=4.8125 std=47.580467224121094

ベンチマーク

halfkp_1024x2-8-64

Total time (ms) : 60004

Nodes searched : 61009382

Nodes_searched/second : 1016755

halfkp_1024x2-8-32

Total time (ms) : 60017

Nodes searched : 62024216

Nodes_searched/second : 1033444

レーティング測定

対局数=5000 同時対局数=64 ハッシュサイズ=384 開始手数=24 最大手数=320 開始局面ファイル=C:\Jenkins\workspace\TanukiColiseum.2023-04-16\TanukiColiseum\bishop_exchange.2023-06-25.sfen NUMAノード数=1 表示更新間隔(ms)=3600000

思考エンジン1 思考エンジン2

name YaneuraOu NNUE 7.63 64ZEN2 TOURNAMENT YaneuraOu NNUE 7.63 64ZEN2 TOURNAMENT

author by yaneurao by yaneurao

exeファイル C:\Jenkins\workspace\TanukiColiseum.2023-04-16\engine1\source\YaneuraOu-by-gcc.exe C:\Jenkins\workspace\TanukiColiseum.2023-04-16\engine2\source\YaneuraOu-by-gcc.exe

評価関数フォルダパス D:\hnoda\shogi\eval\tanuki-.nnue-pytorch-2024-04-30 D:\hnoda\shogi\eval\tanuki-.nnue-pytorch-2024-04-26

定跡手数 256 256

定跡ファイル名 no_book no_book

思考ノード数 0 0

思考ノード数に加える乱数(%) 0 0

思考ノード数の乱数を1手毎に変化させる False False

持ち時間(ms) 300000 300000

秒読み時間(ms) 0 0

加算時間(ms) 2000 2000

乱数付き思考時間(ms) 0 0

スレッド数 1 1

BookEvalDiff 30 30

定跡の採択率を考慮する false false

定跡の手数を無視する false false

SlowMover 100 100

DrawValue -2 -2

BookEvalBlackLimit 0 0

BookEvalWhiteLimit -140 -140

FVScale 16 16

Depth=0 0

MinimumThinkingTime 1000 1000

対局数5000 先手勝ち1763(52.8%) 後手勝ち1578(47.2%) 引き分け1659

engine1

勝ち1597(47.8% R-10.2 +-9.6) 先手勝ち831(24.9%) 後手勝ち766(22.9%)

宣言勝ち95 先手宣言勝ち48 後手宣言勝ち47 先手引き分け856 後手引き分け803

engine2

勝ち1744(52.2%) 先手勝ち932(27.9%) 後手勝ち812(24.3%)

宣言勝ち82 先手宣言勝ち41 後手宣言勝ち41 先手引き分け803 後手引き分け856

1597,1659,1744

学習ロスと検証ロスは、halfkp_1024x2-8-32 より低くなった。

ベンチマークは halfkp_1024x2-8-32 に比べて 5% 程度遅かった。

自己対局は tanuki-.nnue-pytorch-2024-04-26 に対し、レーティングが R10.2 低く、有意な差があった。

考察

学習ロスと検証ロスが halfkp_1024x2-8-32 より低かった理由は、隠れ層第 3 層のチャンネル数が増え、表現力が増したためだと思う。

ベンチマークが halfkp_1024x2-8-32 に比べて遅かった理由は、隠れ層第 3 層のチャンネル数が増え、演算回数が増えたためだと思う。

自己対局でレーティングが tanuki-.nnue-pytorch-2024-04-26 より低かった理由は、学習データに対する過学習だと思う。ネットワークによっては、 Suisho10Mn_psv で Fine-tuning しないほうが強い場合があるということだと思う。

まとめ

halfkp_1024x2-8-64 ネットワークを学習させ、レーティングを測定した。ランダムパラメーターからの学習には、 Hao を用いて生成した学習データを用いた。Fine-tuning に Suisho10Mn_psv を学習データとして用いた。

自己対局は tanuki-.nnue-pytorch-2024-04-26 に対し、レーティングが R10.2 低く、有意な差があった。自己対局でレーティングが tanuki-.nnue-pytorch-2024-04-26 より低かった理由は、学習データに対する過学習だと思う。ネットワークによっては、 Suisho10Mn_psv で Fine-tuning しないほうが強い場合があるということだと思う。

次回は halfkp_1024x2-8-96 ネットワークを学習させ、レーティングを測定したい。